1. 서 론

2. 2자유도 매니퓰레이터 기반 모바일 로봇

2.1 균열 지도 작성을 위한 모바일 로봇

2.2. 연속적 균열 추적 및 균열 지도 작성 기법

3. 실험 검증

3.1 실험 환경 구축

3.2 알고리즘 파라미터 설정

3.3 실험 결과

4. 결 론

1. 서 론

구조물 및 건설인력의 노후화가 진행됨에 따라 구조물 건전도 진단의 자동화 기술이 주목받고 있다(Kim et al., 2015). 이에 따라 구조물 진단의 효율성과 정확도를 높이고 인력 의존도를 줄이기 위한 다양한 기술이 개발되고 있다. 특히 기계학습과 영상처리 기술을 활용한 표면손상 자동 검출, 드론과 지상형 모바일 로봇을 이용한 자동화 플랫폼 등 소프트웨어와 하드웨어 기술이 등장하고 있다(Kim et al., 2017).

콘크리트 구조물의 표면 손상을 진단하는 방법으로 허프 변환, 위상 기반 필터 등의 영상처리 기법이 널리 사용되어 왔다. 최근에는 기계학습을 활용한 네트워크 개발이 활발히 이루어지고 있는데(Bang et al., 2021; Hsieh and Tsai, 2020; Nguyen et al., 2014; Sohn et al., 2004), Faster-RCNN, SSD, VGG, ResNet, Mask RCNN 등 다양한 백본 네트워크와 모델을 활용해 균열 유형을 분류하고 균열 영역을 탐지하는 연구가 대표적이다(Kim et al., 2019). 또한 인코더-디코더 기반 모델, 다운 샘플링 과정의 정보 손실을 최소화하는 풀링 레이어 수정 모델, 순환 신경망(RNN), 생성적 적대 신경망(GAN) 등을 활용한 균열 세분화 연구도 진행되고 있다(Ji, 2021). 더 나아가 기존의 네트워크를 활용하는 데 그치지 않고 CrackNet, HrSegNet 등과 같은 균열탐지에 특화된 새로운 네트워크 개발도 진행되었으며, 이를 통해 균열의 세부 정보를 추출하고, 실시간으로 진단한다(Li et al., 2023).

무인 항공기 및 무인 지상 차량(UGV: Unmanned Ground Vehicle) 등의 자동화된 플랫폼을 활용한 사례도 증가하고 있다(Baek et al., 2023; McNeal, 2016; Meng et al., 2023; Yu et al., 2007; Yuan et al., 2022). 특히 드론을 이용한 대형 토목 구조물의 외부 손상 진단과 UGV를 활용한 실내 표면 손상 진단 연구가 주목받고 있다. Yu 등(2007) 및 Yuan 등(2022)은 UGV 및 비전 센서 기반 실내 균열 지도를 작성하는 기술을 개발하였다. 그러나 이러한 기술들은 플랫폼의 제원 및 센싱 영역의 한계로 인하여 실내에서 사각영역이 발생하게 되고, 자동화된 위치인식 및 지도 작성보다는 벽면 추적 알고리즘 혹은 사용자의 원격 조정기 등을 통하여 UGV의 움직임을 제어한다는 한계점이 있다.

이에 본 논문에서는 2 자유도 매니퓰레이터를 장착하여 사각영역을 최소화하고자 하였으며, 영상처리 및 머신러닝 알고리즘을 활용한 연속적 균열 추적 및 모니터링 시스템을 개발하였다. 이 시스템은 균열이 검출 영역을 벗어나 분할되어 촬영된 경우, 균열의 진행 방향을 예측하고, 매니퓰레이터를 동작시켜 연속적으로 촬영할 수 있도록 한다. 이를 통해 분절된 균열 정보를 끊김 없이 획득하여 전체 균열의 형상과 특성을 정확히 계측할 수 있도록 하였다. 또한, ROS(Robot Operating System)를 활용한 로봇 자율 주행 관련 기술을 구현하였으며, 균열의 검출 정보가 구축된 균열 지도에 표기될 수 있도록 하였다.

2. 2자유도 매니퓰레이터 기반 모바일 로봇

2.1 균열 지도 작성을 위한 모바일 로봇

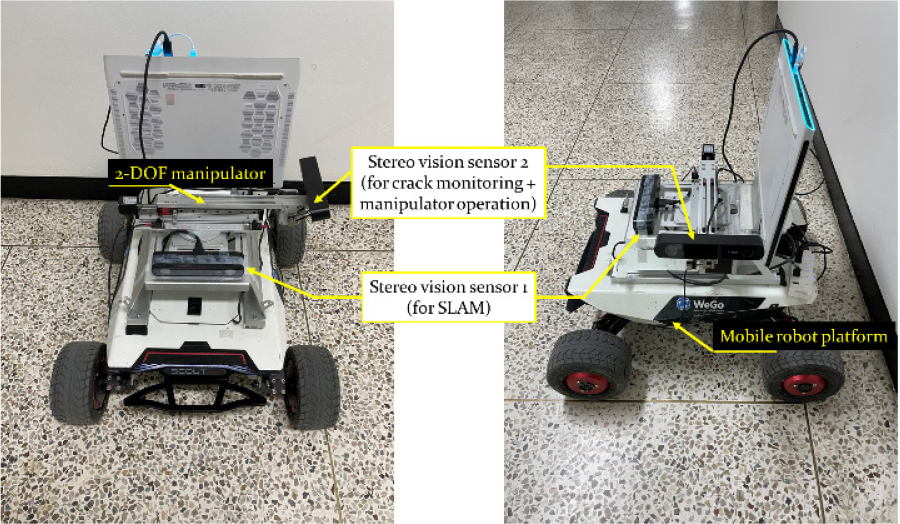

스테레오 비전 센서를 활용하여 실시간으로 모바일 로봇의 위치를 인식하고 지도를 작성하며, 검출된 균열의 위치를 생성된 지도에 표기할 수 있는 균열 지도 생성 시스템을 개발하였다. 상용화된 모바일 플랫폼(㈜WeGo 로보틱스, ST mini)에 개발된 2자유도 매니퓰레이터를 장착하였으며, 회전 및 선형 모터를 이용하여 모니터링 센서 기준으로 앞뒤 및 상하 방향의 움직임이 가능하도록 하였다. 또한, 모바일 플랫폼이 모니터링 센서 기준으로 좌우로 움직이면서 3축 스캐닝이 모두 가능하도록 설계하였다(Fig. 1 참조).

컨트롤러와 컴퓨터는 RS 232 통신을 이용하여 1:1통신을 수행하고, 모터 드라이버를 통해 선형 및 회전 모터를 구동 및 통제하였다. 컴퓨터에서 컨트롤러로 헤더, 주소, 명령, 체크섬의 4개의 데이터 구문을 갖는 메시지 프로토콜을 구성하였고, 이를 전달하여 선형 모터의 앞, 뒤 이동 및 중지와 회전 모터의 위, 아래 회전 및 중지를 명령하였다. 선형 모터는 매니퓰레이터의 길이를 제어하고 회전 모터는 매니퓰레이터의 끝단에 설치된 카메라의 각도를 제어한다.

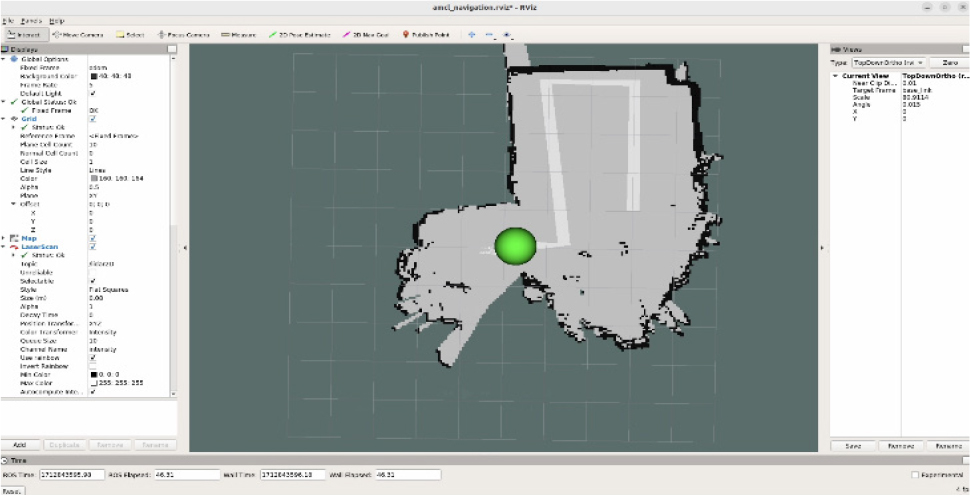

로봇 플랫폼 정면에 설치된 스테레오 비전 센서를 이용하여 뎁스 영상을 확보하고, ROS 환경에서 Gmapping 알고리즘을 사용하여 포인트 클라우드 기반 경로 계획 및 추종을 위한 지도를 작성하였다. 작성된 지도를 기반으로 경로를 생성하고, 생성된 경로에 따라 순차적으로 이동할 수 있도록 구현하였다. 동적 장애물 회피 구현 및 회피 성능 향상을 위하여 스테레오 비전 센서에서 취득한 포인트 클라우드 데이터로부터 깊이 정보를 획득하고, 좌측, 중앙, 우측 방향의 깊이(거리) 값에 따른 회피 알고리즘을 구현하였다.

2.2. 연속적 균열 추적 및 균열 지도 작성 기법

본 연구에서는 스테레오 비전 센서를 기반으로 한 연속적 균열 추적 알고리즘을 개발 및 적용하였다. 스테레오 비전센서의 조도별, 각도별 성능 확인을 위하여 조도 및 벽면체를 각각 두 종류씩 구별 및 적용하여 센서 성능을 확인하였으며, 1.2~2.5m 거리 내에서 상대오차 1% 이내로 각 60mm 크기의 수평 및 수직 길이를 계측함을 확인하였다. 센서의 운용거리를 고려하여 로봇을 작동시키고, 균열을 검출하며, 검출된 균열이 영상 프레임을 벗어나는 경우 2자유도 매니퓰레이터를 이용하여 센서를 제어하고 균열의 전체 형상을 추적한다. 또한, 균열의 진행 방향을 예측하여 센서를 해당 위치로 이동시킴으로써 끊김 없는 균열 이미지를 획득할 수 있도록 하였다. 모든 지역을 스캐닝한 뒤, 최종적으로 획득된 균열 정보는 지도에 해당 위치와 함께 표기하여 실시간으로 저장된다.

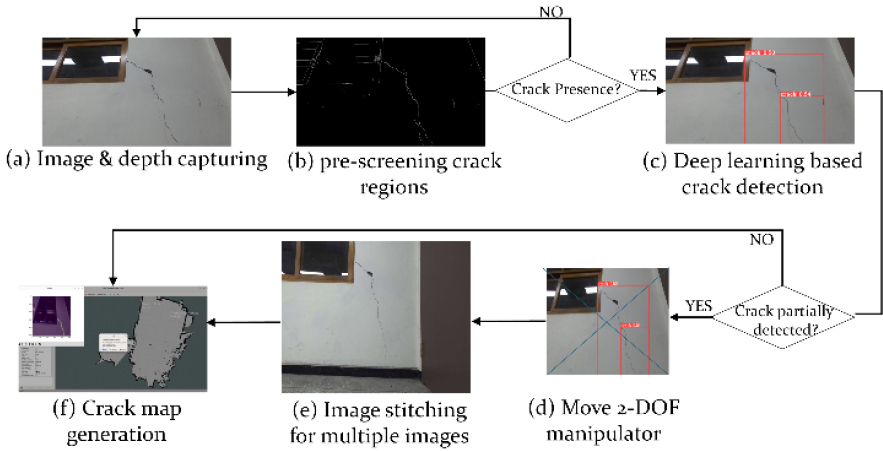

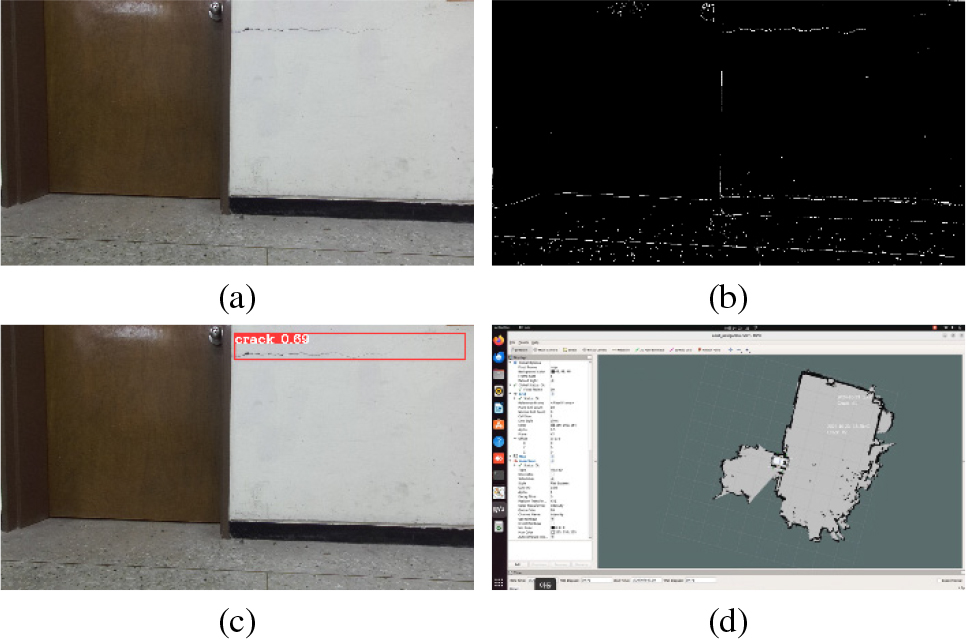

Fig. 2에서 보는 바와 같이 실시간 균열 지도 작성을 위하여 캐니 엣지 검출 알고리즘을 적용하여 균열의 존재 여부를 판단한다. 균열이 존재한다고 판단되는 경우 균열의 위치에 따라 매니퓰레이터의 동작 여부를 결정하고, 균열 전체가 하나의 연속된 영상으로 촬영된 경우, YOLOv6 딥러닝 아키텍처를 사용하여 균열을 검출하도록 하였다. 균열이 영상의 경계에 위치하는 경우를 분할촬영 상황으로 판단하여 매니퓰레이터를 동작시키는 알고리즘의 슈도 코드는 Table 1과 같다. 검출된 균열 정보는 사용자에게 효율적으로 전달 및 저장될 수 있도록 검출 일시와 함께 지도에 표기할 수 있도록 하였다. 로봇의 정면에 설치된 스테레오 비전 센서를 기반으로 구축된 실내 환경 지도와 측면의 매니퓰레이터 끝단에 설치된 센서로 검출된 균열 정보는 두 센서 간 위치 정보를 바탕으로 좌표 변환을 수행하여 정합한다.

Table 1.

Psuedo code for manipulator operation

3. 실험 검증

3.1 실험 환경 구축

균열 지도 작성을 위한 모바일 로봇의 성능을 검증하기 위해 Fig. 3(a)와 같이 실내 환경 기반의 실험을 수행하였다. 벽면에 수직 및 수평 균열이 존재하는 실내 환경에서 모바일 로봇이 주변 환경을 스캔하여 지도를 구축하고, 균열을 검출한 후 이를 통합하여 종합적인 균열 지도를 작성하는 성능을 평가한다. 자율 주행 성능을 확인하기 위하여, Fig. 3(b)와 같이 실내 환경 내 장애물을 설치하고 이에 따른 회피, 기존 경로로의 복귀 및 추종 성능을 확인하였다.

상용화된 로봇 플랫폼(㈜WeGo, ST-mini) 및 스테레오 비전 센서(StereoLabs, ZED 2i)를 사용하였으며, 해당 센서를 이용하여 RGB 및 깊이 영상을 촬영하였다. 딥러닝 기법의 적용을 위해 AMD Ryzen9 5900X 12코어 프로세서(3.70GHz), 32GB RAM, 그리고 NVIDIA GeForce RTX 3080Ti 듀얼 그래픽 카드로 구성된 노트북을 사용하였다.

3.2 알고리즘 파라미터 설정

위치 인식 및 지도 작성에는 Gmapping 라이브러리, 경로 생성 및 추종에는 A* 라이브러리를 사용하였으며, 장애물 회피는 우측, 정면, 좌측의 세방향의 거리 값을 기반으로 장애물 인식 및 회피 알고리즘을 작성하였다. 위 알고리즘은 모두 ROS 환경에서 실시간으로 실행되도록 구현하였으며 사용된 파라미터들은 Table 2와 같다. 균열 검출은 캐니 엣지 검출 및 YOLOv6 딥러닝 알고리즘을 사용하여 구현하였다. 자율 주행 및 균열 검출 알고리즘에서 사용된 파라미터들은 Table 2과 Table 3에 각각 제시되어 있다. Table 3에서 균열 검출에 사용된 딥러닝 파라미터 중 신뢰도 임계 값은 균열 판정의 기준으로 사용되었으며, IoU 임계 값은 두 개 이상의 바운딩 박스가 감지된 경우 IoU 값이 설정된 임계 값을 초과하면 하나의 균열로 간주하였다. 이 파라미터들은 알고리즘의 정확도 뿐만 아니라, 연산의 실시간성을 높이기 위해 시행 착오를 거쳐 최적화한 값들이다.

Table 2.

Parameters used in autonomous navigation of mobile robots

Table 3.

Parameters used in crack detection

| Process | Parameter | Value |

| Crack Pre-screening | Lower threshold | 100 |

| Upper threshold | 200 | |

| Crack detection | confidence threshold | 0.25 |

| IoU threshold | 0.45 |

3.3 실험 결과

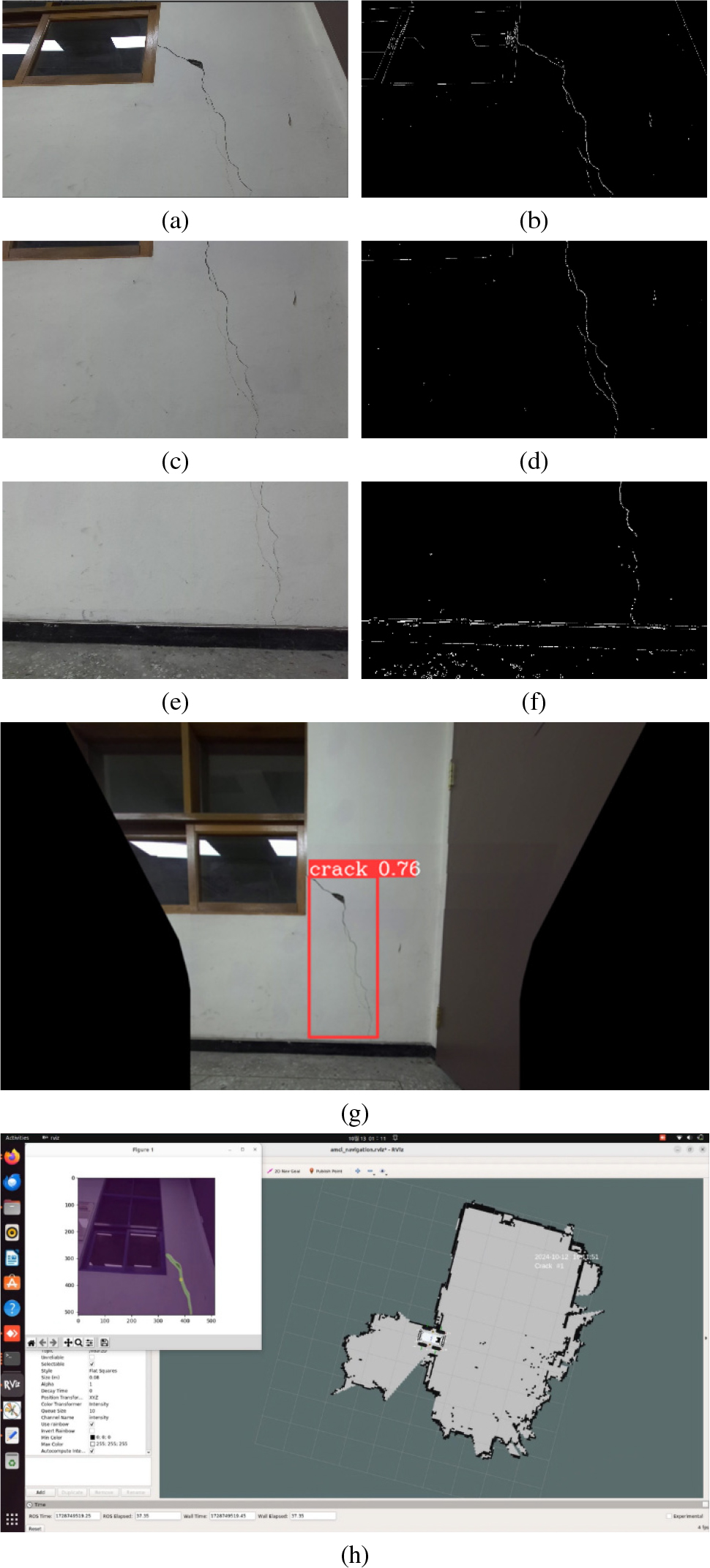

2자유도 매니퓰레이터가 탑재된 모바일 로봇 플랫폼을 이용하여 지도를 작성하고, 벽면에 존재하는 수직 및 수평 균열을 검출하여 구축된 지도에 표기하였다. 사용자가 입력된 경로를 따라 로봇이 이동하면서 벽면의 균열을 검출하도록 하였으며, 구축된 격자기반 SLAM알고리즘을 활용하여 실시간으로 지도를 작성하였다(Fig. 4 참조).

수직 균열의 경우 그 길이가 길어 로봇의 수평 위치에서 획득한 영상에 균열이 온전히 포함되지 않았다(Fig. 5(a), 5(c), 5(e) 참조). 이에 따라 Table 1에서 제시한 매니퓰레이터 작동 알고리즘을 통해 균열의 연속적인 방향을 추정하고, 매니퓰레이터를 동작시켰다. 동작 전후의 원본 영상, 캐니 엣지 검출 결과, 스티칭(stitching) 결과, 그리고 딥러닝 기반의 균열 검출 결과는 Fig. 5와 같다. 수평 균열의 원본, 캐니 엣지 검출, 딥러닝 기반의 균열 검출 및 지도내 균열 위치가 표기된 모습은 Fig. 6와 같다. 수평 균열의 경우 진행방향과 로봇의 경로가 일치하여 매니퓰레이터의 동작 없이 로봇이 진행하며 촬영하고, 검출하였다.

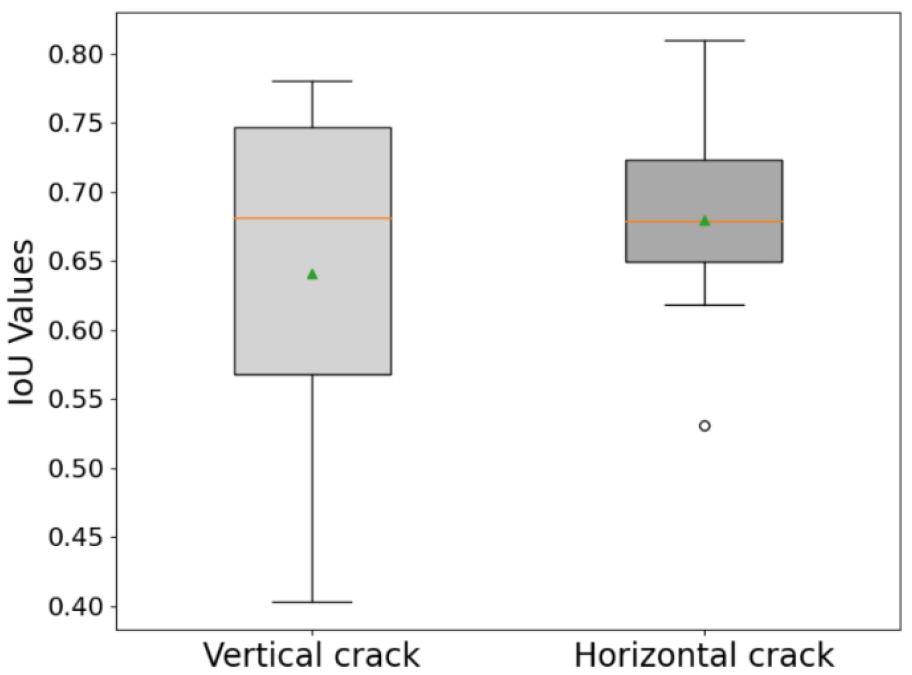

검출된 수직 및 수평 균열의 평균 IoU값은 각각 0.68, 0.64이고, 결과 사진과 같이 검출된 균열 정보가 균열 지도에 안정적으로 표기 및 갱신되는 모습을 확인하였다. 검출된 IoU정보는 각 균열별로 획득된 10장의 영상 프레임 정보를 기반으로 산출하였으며, 해당 결과는 Fig. 7과 같다. 영상 획득, 균열 검출, 균열의 진행 방향 및 사각영역을 고려한 매니퓰레이터의 경로 생성・동작, 작성된 지도 위 표기까지 각 균열 당 평균 6.46초가 소요되었다.

4. 결 론

본 논문에서는 균열 지도 작성을 통한 구조물 진단의 무인화 및 자동화를 위해 스테레오 비전 센서를 장착한 무인 지상형 로봇을 활용하는 방법을 제안하였다. 제안한 균열 지도 작성 모바일 로봇 시스템은 2자유도 매니퓰레이터를 장착하여 사각 영역을 최대한 줄일 수 있도록 개발되었다. 균열의 진행 방향에 따라 모바일 로봇 혹은 매니퓰레이터를 실시간으로 구동하도록 알고리즘을 구현하였다. 실시간성 향상을 위하여 캐니엣지 검출 알고리즘을 선제적으로 적용하고, 일정 조건을 만족하는 경우 영상을 저장 및 딥러닝 기반 균열 검출을 수행하였다.

검출된 균열 정보를 바탕으로 매니퓰레이터의 동작여부를 결정하고, 연속된 균열 영상을 스티칭하여 단일 영상으로 인식할 수 있도록 하였다. 최종적으로는 자율주행을 위한 로봇 정면의 스테레오 비전 센서와 이를 바탕으로 구축된 지도, 그리고 측면의 매니퓰레이터로부터 획득한 신호를 바탕으로 구축된 균열 정보를 좌표계 변환을 통해 통합하여 균열 지도를 구축하였다. 향후 연구로는 매니퓰레이터의 동작 범위를 확대하여 모니터링 영역을 확대하며, 다양한 환경에서의 자율주행이 원만하게 진행될 수 있도록 장애물 인식 및 경로 재계획에 대한 연구, 현장 실험 및 성능 검증 등을 수행할 예정이다. 또한 센서의 포인트 클라우드 성능 분석을 바탕으로 균열의 정량화를 수행하며, 균열의 크기 및 폭 정보를 추가한 균열 지도를 작성하고자 한다.