1. 서 론

2. 선행연구 분석

2.1 균열탐지기술

2.2 균열 데이터

2.3 이미지 전처리 기술

3. 균열 데이터의 취득과 신경망 모델

3.1 공공 데이터 기반 균열 탐지

3.2 데이터 증강

3.3 신경망 모델

3.4 모델 성능 평가 지표

4. 이미지 데이터 전처리

4.1 이미지 필터 및 정규화 적용

4.2 색상 모델의 적용

5. 딥러닝을 이용한 오탐균열 판별

5.1 이미지 필터 및 색상모델을 이용한 오탐균열 판별

5.2 오탐균열 판별을 위한 딥러닝 학습결과 분석

6. 결 론

1. 서 론

콘크리트 구조물에서 발생하는 균열은 구조물의 안전성과 주거 환경에 영향을 준다. 특히 공동주택 외벽 균열을 통해 유입되는 우수는 곰팡이를 발생시켜 주거환경을 악화시키는 주요한 하자 요인이 된다(Golewski, 2023; Rouchier et al., 2013). 따라서 MOLIT(2016)에서는 콘크리트 구조물에서 발생하는 균열 기준을 명시하고 있다. 콘크리트 구조설계 기준에서 허용 균열 폭은 건조환경의 경우 0.4mm로 제한하며, 습윤환경의 경우 0.3mm로 제한하고 있다. 이러한 균열 탐지는 콘크리트 품질 관리자가 육안으로 수행하는 것이 용이하지 않은 경우가 많기 때문에 컴퓨터 비전 기술을 활용해 콘크리트 구조체 균열을 자동으로 탐지하기 위한 다양한 연구가 진행되어 왔다(Hutchinson and Chen, 2006; Ji et al., 2021; Lee et al., 2023).

초기 컴퓨터 비전 기반 연구의 경우 이미지의 초점거리, 촬영 환경 및 품질 등에 따른 노이즈 제거를 위해 각각의 필터를 모델링하는 규칙 기반 방식(Rule-based method)으로 연구가 많았으나, 최근에는 AI 기술 중 하나인 딥러닝 기술을 적용하는 연구가 활발히 진행되고 있다(Hamishebahar et al., 2022; Kim et al., 2019; Shin and Won, 2023). 다만, 기존의 연구 방법에서 사용된 대부분의 학습 데이터는 오염되지 않은 콘크리트 단일 재료에 균열이 존재하는 공공 데이터이다. 이로 인해 기존의 연구 방법으로 공동주택 외벽의 균열을 탐지하는 경우 기대하는 수준의 정확도와 재현율을 얻기 어려운데, 이는 시공 중인 공동주택 외벽의 경우 창호, 환기설비, 가시설물, 음각・양각 무늬 등 기존의 균열 데이터와 다른 다양한 객체를 포함하고 있기 때문이다. 이에 본 연구에서는 균열 공공 데이터로 건물 외벽 균열을 탐지할 때, 반복적으로 균열로 분류되는 비균열 형태를 ‘오탐균열(false-positive-crack)’으로 정의하고, 이러한 오탐균열을 비균열로 분류하기 위한 효과적인 방법론에 대한 비교 분석을 실시하였다.

2. 선행연구 분석

2.1 균열탐지기술

비전 기반 균열 탐지 기법 자동화를 위한 초기 연구에서는 엣지 필터, 이미지 정규화와 같이 균열 부위의 형상을 강조하기 위한 다양한 이미지 처리 기법이 연구되었다(Ji et al., 2021; Kim et al., 2023; Lee et al., 2023; Parrany and Mirzaei, 2021). 이후 객체 탐지를 위한 딥러닝 기술이 급격히 발달하면서 기존의 이미지 처리 기법은 데이터 전처리 단계에서 사용하고 전 처리된 데이터를 딥러닝으로 학습하여 균열을 탐지하는 자동화 기술이 다양하게 연구되고 있다(Kim et al., 2019; Shin and Won, 2023).

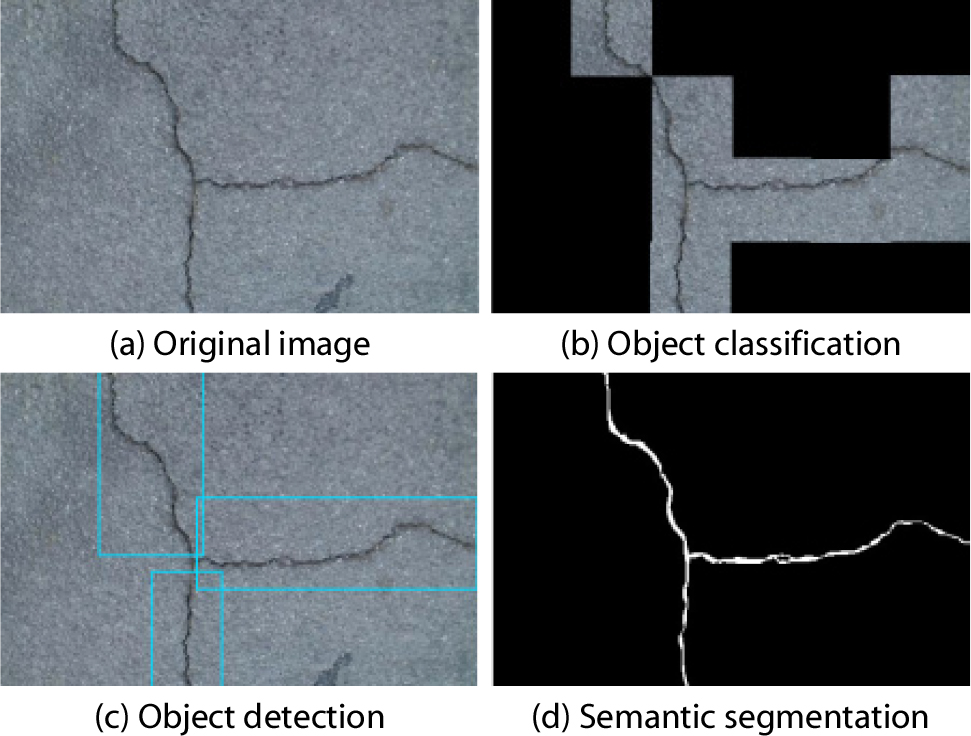

딥러닝 기반 객체 탐지의 핵심 알고리즘은 CNN(Convolutional Neutral Network)으로 과거 사람의 인지에 의해 대상 탐지물의 특징을 확인하던 작업을 컴퓨터 학습이라는 과정을 통해 사람의 인지 없이 구분할 수 있게 해준다. CNN을 기반으로 하는 객체 탐지는 그 방식에 따라 하나의 이미지에서 하나의 객체만을 탐지하는 객체 분류(Object classification) 모델과 하나의 이미지에서 여러 개의 객체를 사각형 형태로 탐지하는 객체 검출(Object detection) 모델 그리고 하나의 이미지에서 픽셀 단위로 객체를 탐지하여 형상에 따라 표현할 수 있는 의미적 분할(Semantic segmentation) 모델과 같이 총 세 가지로 구분할 수 있다. 최근의 연구들은 균열과 같은 선형 객체를 시각화하는 의미적 분할 모델을 개발하여 적용하는 방법을 중심으로 이루어지고 있다(Hamishebahar et al., 2022). 하지만 의미적 분할 모델의 경우, 균열 데이터에 픽셀 단위로 표시를 해주어야 하므로 데이터 생성에 많은 시간이 소요된다(Hamishebahar et al., 2022). 이에 본 연구에서는 Hutchinson과 Chen(2006), Kim 등(2018)에 소개된 방법과 마찬가지로 윈도우 슬라이딩 방식의 분류 모델을 사용하였다. Fig. 1은 이미지 탐지 모델의 예를 보여준다.

균열 탐지에 사용되는 CNN 모델의 경우 연구 초기에는 자체적으로 개발하는 사례가 많았으나, 최근에는 충분히 검증된 다양한 이미지 탐지를 위한 CNN 모델이 제공되고 있기 때문에 해당 모델의 핵심 형태를 그대로 사용하되 일부 가중치를 재학습하는 전이학습 방식을 주로 사용한다. 또한, 이러한 모델의 예측 정확도가 대부분 95% 이상으로 나타나기 때문에 모델에 따른 차이점은 크지 않다(Ji et al., 2021; Nam et al., 2022). 따라서 본 연구에서는 공개된 CNN 모델 중 균열 탐지 정확도가 높은 모델을 사용하였다.

2.2 균열 데이터

학습을 기반으로 한 딥러닝의 예측 정확도는 데이터 정확도의 영향을 크게 받는다(Gowda and Yuan, 2019). 일반 사물을 대상으로 하는 객체 탐지에서는 100~1,000여 종의 다양한 사물을 학습할 수 있는 여러 형태의 공공 데이터가 존재(Activeloop, 2024)하며, 이러한 다양한 데이터를 활용하여 이에 대한 예측 모델을 학습하고 평가한다.

한편, 균열 데이터의 경우 일반적인 목적으로 생산된 데이터가 부족하기 때문에 초기 연구에서는 자체 촬영 영상을 활용하여 소규모의 데이터로 연구하는 경우가 대부분이었다(Hoang and Nguyen, 2018). 이후 딥러닝 기반 균열 연구가 활발히 진행되면서 연구기관에서 학습용 균열 공공데이터를 제공하는 사례가 늘어나고 있다(Fig. 2 참조). 그러나 제공된 균열 공공데이터의 경우 대부분 콘크리트 단일 재질의 배경에 짙은 균열이 표현된 형태이기 때문에 공동주택과 같은 다양한 배경의 데이터를 공공데이터에서 확보하는 것은 쉽지 않다. 따라서, 본 연구에서는 공동주택 균열 탐지에 적합한 데이터를 취득하고 이를 자체적으로 가공하여 학습에 활용하였다.

2.3 이미지 전처리 기술

딥러닝 기술에서 특정 객체의 정탐률을 높이고 오탐률을 낮추기 위해서는 해당 객체가 다른 객체와 구별될 수 있는 모양과 색상의 특징을 학습하는 것이 중요하다. 따라서 찾고자 하는 객체와 탐지 대상이 아닌 객체의 모양 및 색상의 차이점을 극대화할 수 있는 다양한 이미지 전처리 기술이 개발됐다. 첫 번째 방법은 균열과 같은 선형 객체를 탐지하는 경우에 사용하는 엣지 필터와 색상 정규화이다. 엣지 필터는 색상 정보 간의 수치 차이가 큰 부분을 경계선으로 인지하여 강조하는 필터이며, 색상 정규화는 주변 밝기로 인해 동일한 대상의 색상이 어둡거나 밝게 표현되는 문제를 해결하기 위해 특정 영역의 색상 정보를 정규 분포 형태로 재구성하는 기법이다. 예를 들어, Kim 등(2018), Hoang과 Nguyen(2018) 및 Cho 등(2018)은 다양한 엣지 필터들을 복합적으로 사용하여 균열 선형정보를 최대한 강조할 방법들을 연구하였으며, Kim 등(2019)은 동일한 이미지가 음영으로 다르게 처리되는 것을 최소화하기 위해 R, G, B 각 채널에 정규화 기법을 적용하여 균열 이미지를 강조할 방법을 연구하였다.

두 번째 전처리 방법은 일반적으로 사용하는 RGB 3채널 이미지 정보 대신 다른 색상 모델을 사용하는 것이다. Gowda와 Yuan(2019)는 비행기, 자동차, 새, 고양이, 사슴, 개, 개구리, 말, 배, 트럭의 10개의 탐지 객체를 대상으로 RGB 색상 모델 외에 HSV, LAB, YUV, YCbCr, YPbPr, YIQ, XYZ, HED, LCH, CMYK 총 10개의 채널로 학습하여 각 색상 모델의 탐지 정확도를 비교하였다. 결과적으로 모든 대상의 탐지 정확도를 높일 수 있는 공통된 색상 모델이 없음을 확인할 수 있었으나, 대상별로 탐지 정확도를 높일 수 있는 모델이 각각 존재한다는 것을 확인하였다. Choi 등(2020)은 송전 설비의 절연체로 사용되는 구형의 자기애자에 발생한 균열 탐지를 목적으로 RGB 색상모델이 아닌 LAB 색상 모델을 사용하여 탐지율을 개선하기도 하였다.

따라서 콘크리트 균열과 같은 특정 객체를 탐지하고자 하는 경우 색상 모델의 영향을 비교하는 것은 의미가 있으며, 현재까지 공동주택 외벽의 오탐균열과 실제 균열을 구분하기 위한 이미지 전처리 관련 연구는 없었다. 본 연구에서는 오탐균열을 실제 균열과 명확하게 구분하기 위한 방법으로 엣지 필터 및 색상 정규화와 색상 모델 변경에 따른 균열 탐지 결과를 비교・검증하고자 한다.

3. 균열 데이터의 취득과 신경망 모델

3.1 공공 데이터 기반 균열 탐지

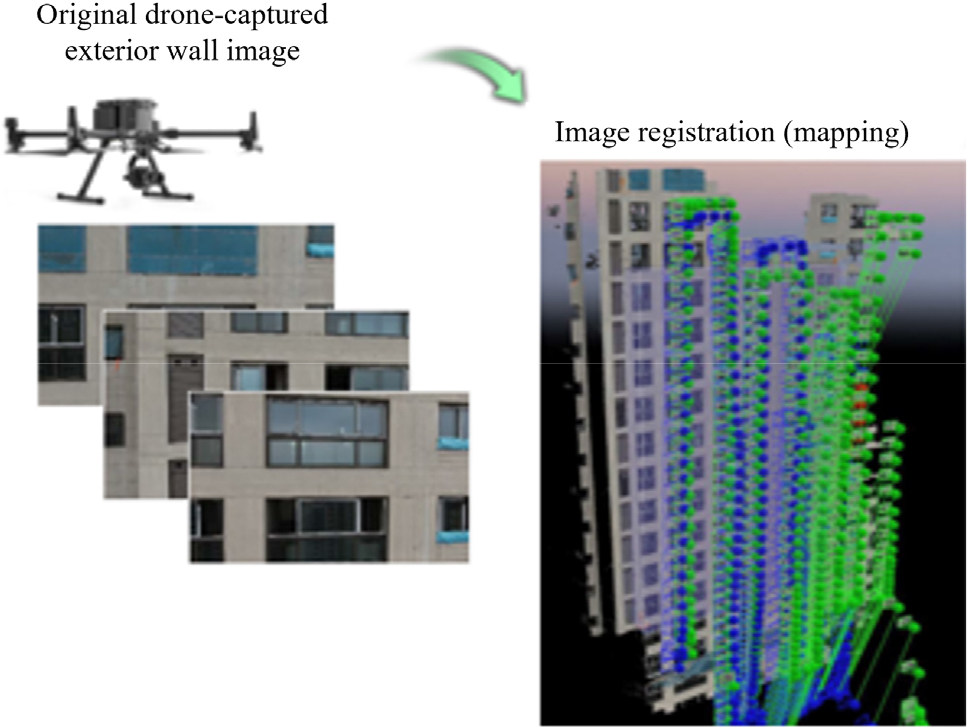

공동주택 시공 중 실제로 발생하는 다양한 형태의 균열과 오탐균열 데이터를 확보하기 위해 본 연구에서는 시공 중인 2개의 공동주택 건설현장에서 이미지 데이터를 취득하였다. 대상 건물은 콘크리트 타설 후 외부 골조작업이 완료되어 거푸집이 제거된 상태의 건축물이다. 탐지 대상인 균열의 폭이 0.4mm 미만이기 때문에 적어도 1픽셀이 표현하고 있는 실제 크기가 0.4mm보다 작아야 한다. 이를 위해서는 근거리 고해상도 촬영이 필수적이기 때문에 드론 근접촬영을 통해 이미지 데이터를 확보하였다. 이렇게 촬영된 개별 이미지에서 정확한 위치 정보를 확보하기 위해서는 개별 이미지를 정합하는 과정이 필요한데, 이 과정은 정합 전용 S/W인 Pix4D를 활용하였다(Fig. 3 참조). 이후 정합된 이미지를 다시 160 × 160 픽셀의 작은 크기로 나누어, 오염되지 않은 콘크리트 단일 재료로 구성된 Kaggle Dataset - Crack(2024)로 탐지를 시행하여, 균열, 비균열로 구분을 하였다. 이후, 균열로 구분된 데이터 중 실제 균열이 아닌 데이터를 육안으로 추려내어 오탐균열 데이터로 분류하였다.

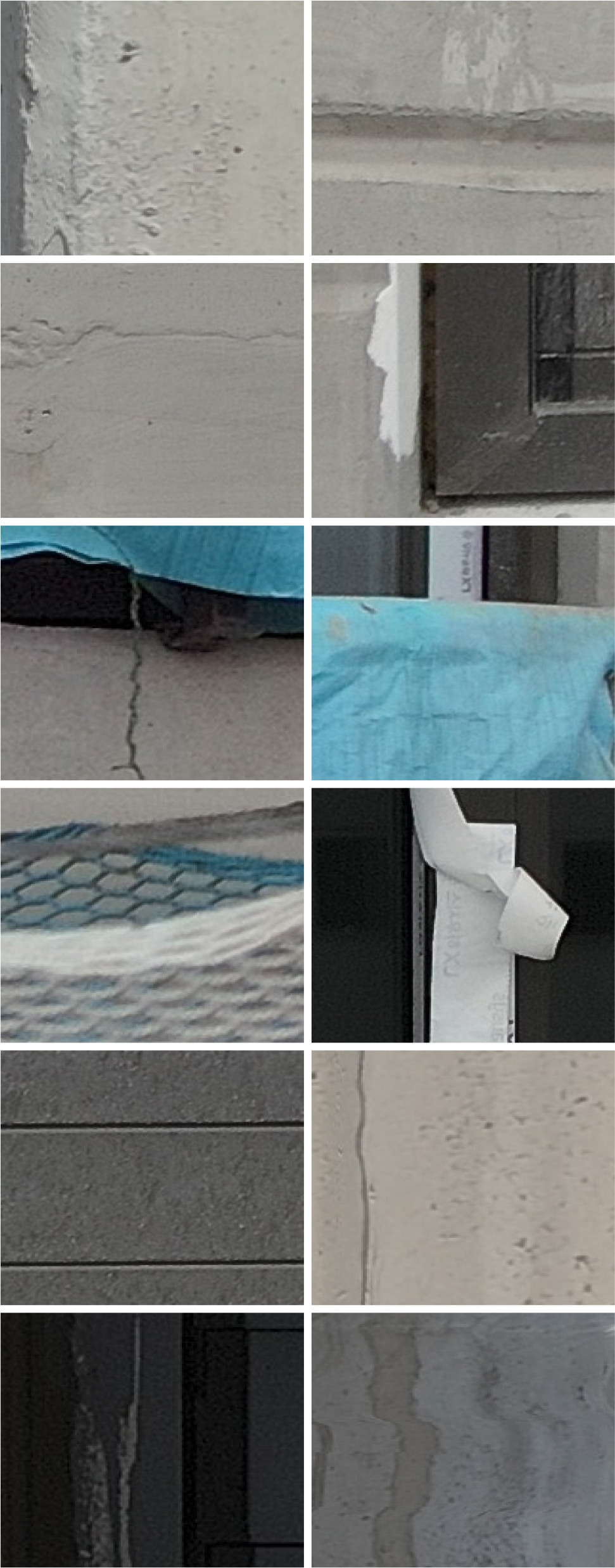

이렇게 구분된 오탐균열 데이터는 Fig. 4와 같은 형태를 가진다. Fig. 4에서 확인 할 수 있듯이 공동주택의 외벽은 다양한 형태의 콘크리트 마감, 복수 색상의 도포가 적용될 뿐만 아니라, 유리를 포함한 창호, 철재 공조설비 및 건설 안전망과 같은 다양한 형태의 구조물이 추가로 설치되어 있으며, 이러한 요소 중 일부 형상이 콘크리트 단일 재료로만 학습된 균열 탐지 모델에서 균열로 오탐되는 것을 확인할 수 있다.

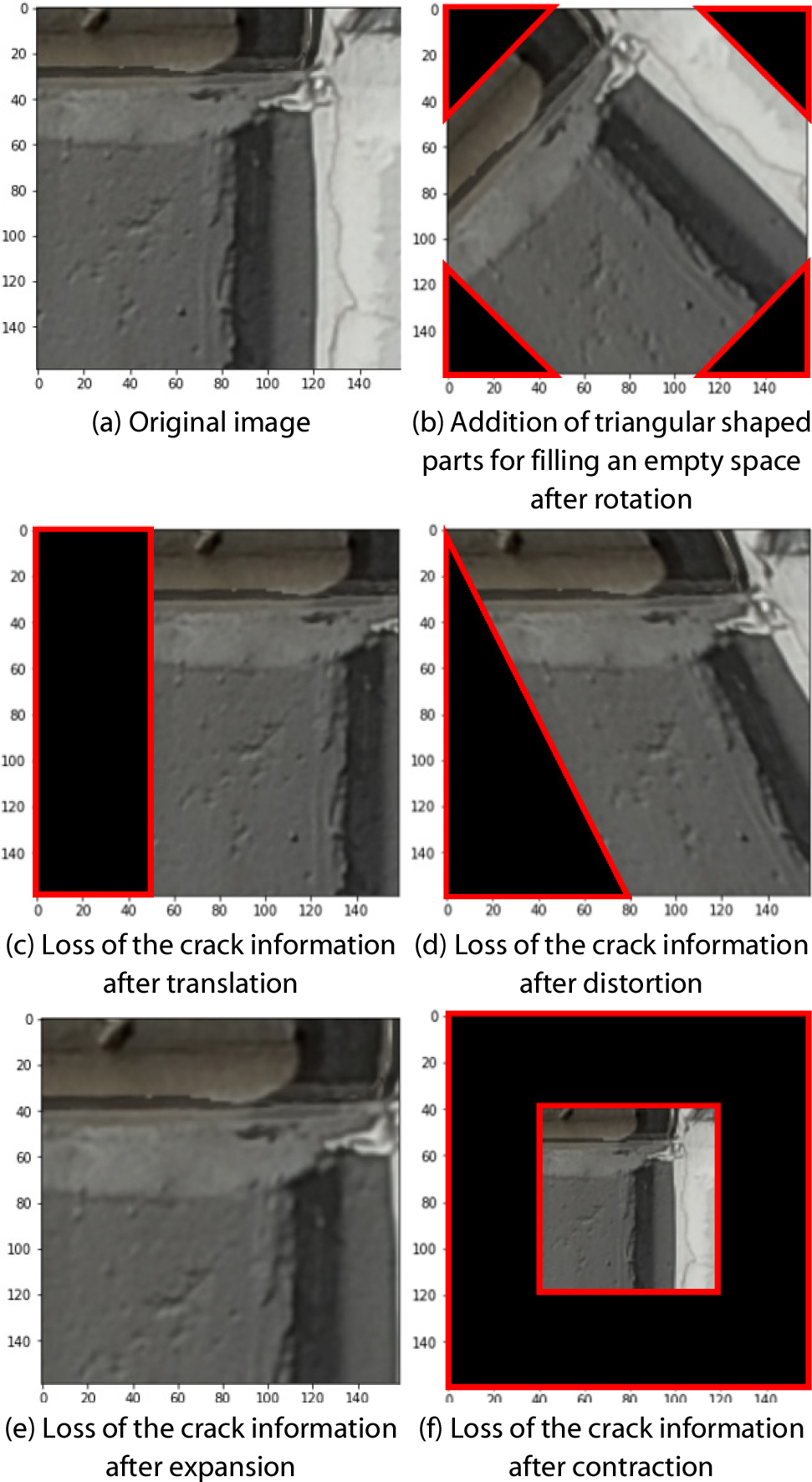

3.2 데이터 증강

데이터 구축 결과, 균열 이미지 데이터는 비균열 이미지 데이터의 1% 미만임을 확인할 수 있었다. 이렇게 한쪽으로 편중된 데이터로 학습을 하는 경우, 절대다수를 차지하는 비균열로 결과가 편중될 가능성이 크기 때문에 균열 이미지 데이터를 추가로 확보할 필요가 있다(Choi and Kim, 2022). 따라서 이미지 탐지에서 사용되는 데이터 증강 기법을 사용하여 균열 이미지 데이터를 확장하였다. 일반적으로 이미지 데이터를 증강하기 위해 ‘회전’, ‘이동’, ‘뒤틀림’, ‘확대・축소’, ‘뒤집기’, ‘명암 변환’을 무작위로 적용하는데, Fig. 5에서 보듯이 균열 정보가 160 × 160 이미지의 한쪽 면에 치우쳐 있는 경우 이러한 일반적인 데이터 증강 과정 중에 탐지 대상이 되는 균열 정보가 이미지에서 사라지거나, 존재하지 않던 절단면 정보가 생성되는 문제가 있다.

본 연구에서는 데이터 증강의 효과를 유지하면서 균열 정보의 변화가 없는 직각 회전(90도, 180도, 270도)과 상하 10개 스케일 즉, 총 20개 스케일의 밝기 변화를 적용하였다. 결과적으로 원본 이미지의 비균열 데이터 세트 53만 개와 더불어 3,542개의 원본 이미지 균열 데이터 세트를 증강하여 오탐균열 이미지 데이터 48만 개와 35만 개의 균열 이미지 데이터를 확보하였다.

3.3 신경망 모델

Kim 등(2018)은 다양한 신경망 모델의 균열 탐지 성능을 비교한 결과를 제시하였는데, 이 연구의 대상 데이터는 비교적 표면이 균질한 교량 이미지 데이터를 사용하였다. 그러나 본 연구는 Kim 등(2018)의 연구와 달리 공동주택 외벽에 대한 이미지 데이터를 대상으로 하므로 여섯 가지 신경망 모델(Keras Modules, 2024)의 성능을 다시 직접 비교・검증하였다(Table 1 참조). 검증을 위해 학습에 사용되지 않은 10%의 테스트 데이터를 대상으로 정확도를 비교하였으며, 결과적으로 성능이 가장 우수한 것으로 나타난 EfficientNet V2s 모델을 연구에 사용하였다.

Table 1.

Accuracy comparison of neural network models

| Neural network models | Accuracy |

| MobileNet V2 | 97.3% |

| MobileNet V3 Small | 98.7% |

| MobileNet V3 Large | 98.8% |

| Inception V3 | 93.7% |

| Dense201 | 98.3% |

| EfficientNet V2s | 98.9% |

공동주택 이미지 대상 오탐균열 판별을 위한 인공 신경망 모델로 선정된 EfficientNet V2s의 학습 파라미터는 Table 2에 정리하였다. 이 모델의 구체적인 매개변수 설정은 다음과 같다. EfficientNet V2s 모델은 총 483개의 레이어로 구성되며, 이 레이어들은 데이터의 복잡한 특징을 학습하는 데 중요한 역할을 한다. 각 레이어는 데이터의 다양한 측면을 학습하며, 초기 레이어는 기본적인 특징을 학습하고 깊은 레이어는 더 복잡한 특징을 학습한다. 모델의 전체 레이어 중 228개는 학습 과정에서 가중치가 업데이트되는 ‘훈련 가능한’ 레이어(Trainable Layers)로 구성되어 있다. 이 레이어들은 손실 함수 최소화를 위해 핵심적으로 조정된다. 네트워크의 가중치를 업데이트하는데 사용한 최적화 알고리즘은 Adam(Optimizer)이다. Adam은 예측 오차를 최소화하기 위한 매개변수 조정 방법을 제공하며, AdaGrad와 RMSProp의 장점을 결합한 효율적인 알고리즘이다. 모델의 학습 속도를 결정하는 중요한 하이퍼 파라미터인 학습률(Learning Rate)은 모델이 너무 빠르거나 너무 천천히 수렴하지 않도록 0.001로 설정하였다. 에포크(Epoch) 수는 모델의 성능과 과적합 위험 사이의 균형을 맞추는 데 중요한 요소인데 적용된 모델은 전체 데이터 셋에 대해 40 에포크 동안 학습된다. 이와 같은 EfficientNet V2s의 매개변수 설정은 공동주택 이미지에서 오탐균열을 판별하는 데 있어 정확성과 효율성의 균형을 제공하며, 특히, 컴퓨팅 리소스가 제한적인 환경에서의 적용 시에 적합하다.

Table 2.

Training parameters of the deep learning model

| Total Layers | 483 |

| Trainable Layers | 228 |

| Optimizer | Adam |

| Learning Rate | 0.001 |

| Epoch | 40 |

3.4 모델 성능 평가 지표

오탐균열에 대한 정량적 판정을 위해 학습에 사용하지 않는 160 × 160픽셀의 이미지 300장을 별도로 준비하였다. 300장의 이미지는 균열 이미지 100장, 비균열 중에서도 오탐균열 이미지 100장, 비균열 중에서 오탐균열이 아닌 이미지 100장으로 구성하였다. 본 연구는 오탐균열 판정 정확도를 비교하려는 목적뿐만 아니라 균열과 비균열 판정 정확도도 함께 확인하기 위해 균열 탐지 지표와 오탐균열 탐지 지표를 구분하여 적용하였다.

평가 지표는 인공지능 모델 평가에 주로 사용되는 정밀도(Precision)와 재현율(Recall)의 조화평균을 사용하였다. 따라서 본 연구는 다음과 같이 균열 탐지 지표와 오탐균열 탐지 지표를 구분하여 적용하고 균열 탐지와 오탐균열 탐지 정확도를 동시에 정량화하여 평가하였다.

먼저, 균열 탐지 지표로 사용한 ‘균열 탐지 조화평균’의 경우, 균열 이미지와 오탐균열이 아닌 일반 균열 이미지를 대상으로 균열이 존재하는 이미지를 ‘참(True)’으로 하고 균열이 존재하지 않는 이미지를 ‘거짓(False)’으로 규정하여 균열 자체의 판정 정확도를 표현한다. 이때, 균열 이미지 데이터 100장, 비균열 이미지 데이터 100장을 사용한다.

반면, 오탐균열 탐지 지표로 사용한 ‘오탐균열 조화평균’의 경우, 비균열 이미지를 정확히 구분하는지를 확인하는 것이 목적이기 때문에 일반 비균열 이미지 100장과 오탐균열이지만 비균열인 이미지 100장을 대상으로 이미지에 오탐균열이 존재하는 것을 ‘참(True)’으로 하고 오탐균열이 존재하지 않는 이미지는 ‘거짓(False)’으로 하여 다음과 같이 계산하였다.

4. 이미지 데이터 전처리

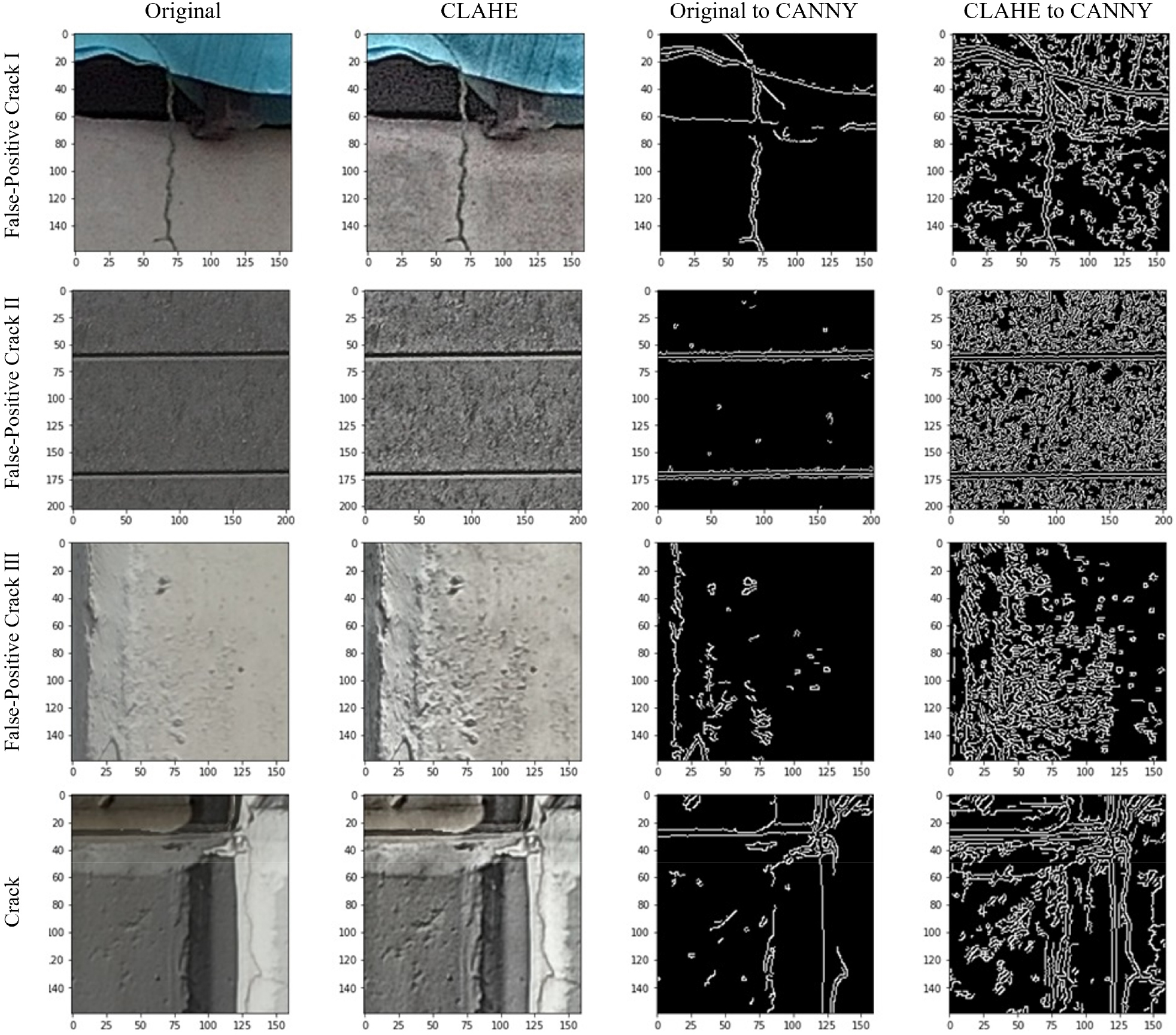

4.1 이미지 필터 및 정규화 적용

이미지 필터는 엣지 필터 중 일반적으로 가장 많이 사용되는 Canny Filter를 적용하였고 정규화는 정규화 기법 중 자주 사용되는 CLAHE 정규화 기법을 사용하였다. 오탐균열 이미지를 전처리한 결과는 Fig. 6에 제시하였는데, CLAHE 정규화 과정은 균열 부위뿐만 아니라, 오탐균열의 형상도 함께 강조하는 것을 확인할 수 있다. 또한, 미세한 오염물이나 경계선도 CLAHE 정규화 과정을 통해 균열과 비균열 정보 모두 강화되는 것을 볼 수 있다. 한편, Canny 엣지 필터의 경우 윤곽 정보만 추출하기 때문에 오탐균열과 균열을 구분할 수 있는 정보들도 함께 삭제될 수 있다는 것을 알 수 있다. 이에 본 연구에서는 정보의 유실이 발생하는 엣지 필터는 적용하지 않았으며, CLAHE 정규화를 적용한 결과와 원본을 비교하여 검증하였다.

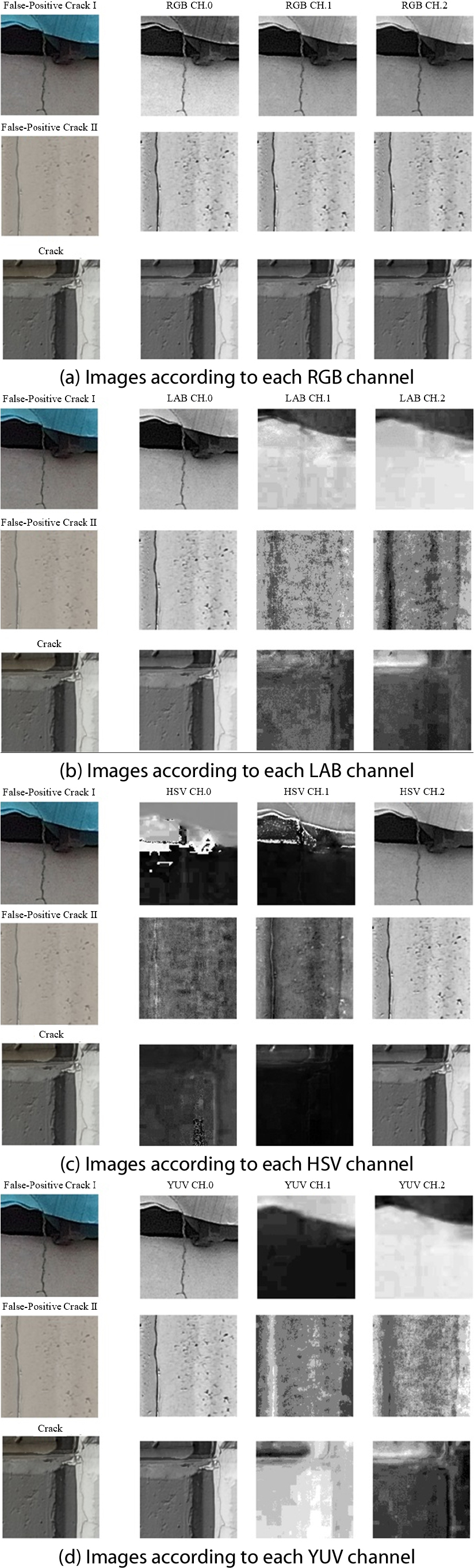

4.2 색상 모델의 적용

본 절에서는 다양한 색상 모델 중에서 자기 애자(porcelain insulator)에 발생한 균열 탐지에 효과가 있었던 LAB와 일반적으로 많이 사용하는 HSV, YUV 색상 모델(Wikipedia - Color Space, 2024)을 비교하였다. RGB는 일반적인 색상 모델로서 색의 삼원색인 Red, Green, Blue를 각 채널에서 표현하는데, Fig. 7(a)는 오탐균열과 균열 이미지의 채널별 정보를 Grayscale로 표현한 것이다.

LAB 색상 모델은 인간의 시각 연구를 바탕으로 만들어진 색상도로서 장비 또는 인쇄 매체에 따라 색상이 달라지지 않는 특성이 있다(Fairchild, 2013). 세 채널 중 첫 번째는 밝기 정보를 표현하고 두 번째 채널은 녹색과 빨간색 사이에서 어느 쪽에 치우쳤는지 정보를 표현하며, 세 번째 채널은 파란색과 노란색 사이에 어느 쪽으로 치우쳤는지를 표현한다. Fig. 7(b)는 오탐균열과 균열 이미지의 LAB 채널별 정보를 보여준다.

HSV는 가시광선 스펙트럼을 색상 표현하는 색조로 구성된 첫 번째 채널과 채도 정보를 표현하는 두 번째 채널, 명도 정보를 표현하는 세 번째 채널로 구성된 색상 모델이다(Smith and Lyons, 1978). Fig. 7(c)는 오탐균열과 균열 이미지의 HSV 채널별 정보로 보여준 예이다.

YUV는 사람이 색상을 인지할 때 밝기에 더 민감하고 색상은 상대적으로 둔감한 점을 고려하여 만든 색상 모델이다(Gowda and Yuan, 2019). 첫 번째 채널은 밝기를 표현하고 두 번째 채널은 밝기와 파란색과의 색상 차를 표현하며, 세 번째 채널은 밝기와 빨간색과의 색상 차를 표현한다. Fig. 7(d)는 오탐균열과 균열 이미지의 YUV 채널별 정보를 표현한 것이다.

이처럼 색상모델에 따라 다양하게 이미지 정보가 분리되는 것을 확인할 수 있다. 또한, 균열과 비균열 정보 모두 밝기와 관련된 정보에 좀 더 민감하게 표현되는 것을 볼 수 있으나, 육안으로 정확한 차이를 인지하기는 어렵다. 딥러닝의 강점이 사람이 판단하기 어려운 정보 간의 연관 관계를 기계학습을 통해 탐지하는 것이므로 딥러닝 학습을 통해 위에서 언급한 네 가지 색상 모델의 성능 및 차별성을 알아낼 수 있다.

5. 딥러닝을 이용한 오탐균열 판별

5.1 이미지 필터 및 색상모델을 이용한 오탐균열 판별

학습 모델을 통해 균열 이미지 100장, 균열이 아니면서 오탐균열인 이미지 100장, 오탐균열이 아닌 일반 균열 이미지 100장을 판별한 결과와 그에 따른 성능 비교 지표들을 Table 3에 정리하였다. 테스트 이미지별 예측 결과에 참인 값은 굵은 폰트로 표기하였다. 균열 이미지의 경우 이미지 처리 전 원본 이미지 대상의 RGB 색상모델 적용 결과가 다른 색상 모델 적용 결과보다 월등히 좋았지만, CLAHE 이미지 전처리 적용 시에는 LAB 색상모델 적용 결과가 가장 좋은 것을 확인할 수 있다.

Table 3.

False-positive-crack detection result according to color models and image filter

일반 비균열 이미지의 경우에는 이미지 전처리 결과와 상관없이 학습결과의 판단이 모두 우수함을 확인하였다. 반면, 오탐균열의 경우에는 색상 이미지 전처리와 색상 모델별로 다양한 결과를 나타냈다. Table 3에서 보듯이 오탐균열을 비균열로 가장 정확히 구분한 색상 모델은 HSV 모델이었다. 단, HSV의 경우 재현율이 현저히 떨어져 대부분의 이미지를 비균열 이미지로 판단하는 편향이 있음을 알 수 있다. 오탐균열을 비균열 이미지로 구분하는 정확도를 보면, 원본 이미지 기준으로 오탐균열을 판별하는 경우 RGB 3원색과의 연계성보다는 YUV와 LAB의 3채널과의 연계성이 조금 더 크게 나타나는 것을 확인할 수 있다.

결과적으로 정규화를 통한 이미지 전처리 효과가 균열, 비균열, 오탐균열을 구분하는 데에는 큰 역할을 하지 못한다는 것을 알 수 있다. 오탐균열 형상을 보이는 비균열 이미지의 경우 RGB 3원색 구분 채널보다는 YUV, LAB의 색상 구분에서 의미 있는 차이를 보이는 것을 확인할 수 있다. 단, 전반적인 평가를 의미하는 조화평균에서는 균열과 오탐균열 모두 RGB 색상 모델을 활용한 결과가 상대적으로 더 우수하게 나타났다.

5.2 오탐균열 판별을 위한 딥러닝 학습결과 분석

본 연구에서는 오탐균열을 어떠한 조건에서도 명확히 구분할 수 있는 최적의 색상 모델은 찾지 못했다. 그러나 테스트 이미지 별로 결과를 분석해 보면, 같은 이미지라도 색상 모델에 따라 확연하게 다른 결과가 나타날 수 있음을 확인했다. Table 4는 각 색상 모델에 대해 균열 가능성을 0~100으로 표기한 결과이다. Table 4에 제시된 그림에서 알 수 있듯이 RGB에서 분명하게 균열로 구분되는 이미지라도 다른 색상 모델에서는 균열의 가능성을 0으로 보는 경우가 있으며, 반대로 RGB에서 균열 가능성을 0으로 보았으나, 다른 모델에서는 균열을 제대로 탐지한 사례도 확인할 수 있다. 따라서 하나의 색상 모델에만 의존하여 균열을 탐지하는 것은 바람직하지 않으며, 오히려 여러 색상 모델로부터 얻어진 탐지 결과를 종합적으로 분석하여 균열에 대한 판정을 내리는 것이 훨씬 더 판정의 신뢰도를 높일 방법이라는 결론을 얻을 수 있다. 다만, 더욱 합리적인 판단을 내리기 위해 색상 모델별 가중치를 도입하는 것은 고려해볼 필요가 있으며, 균열 가능성 수치가 극단적으로 나타날 때 대해서는 추가적인 연구가 필요하다.

Table 4.

Crack detection result according to color model

| Image | RGB | YUV | LAB | HSV |

| 100 | 100 | 100 | 100 |

| 100 | 0 | 0 | 99 |

| 88 | 35 | 0 | 0 |

| 0 | 3 | 99 | 0 |

오탐균열 이미지의 경우 Table 5와 같이 다른 색상 모델에서는 제대로 판단하는 데 반해 RGB 모델에서 균열로 잘못 인식한 결과가 나온 경우를 확인할 수 있다. 이것은 각색상모델이 이미지의 특징점을 다르게 학습한다는 것을 보여준다. 따라서 향후 색상 모델별 특징을 적절히 조합하여 균열 이미지 탐지 성능을 최적화한 이미지 필터를 개발하고 균열 탐지 정확도를 더욱 높일 방안을 추가적으로 연구할 필요가 있다.

6. 결 론

본 연구에서는 딥러닝을 활용하여 공동주택 외벽의 균열 탐지 결과에 영향을 주는 오탐균열을 정의하고 그 오탐균열을 균열 데이터로부터 구분하기 위한 다양한 이미지 전처리 기법을 제시하고 비교・검증한 결과를 제시하였다.

공동주택 외벽 균열 탐지의 경우 균열 탐지에서 자주 적용되는 정규화 기법이 크게 영향을 미치지 못했다. 특히, 오탐균열 탐지의 경우 정규화 기법을 적용한 결과가 오히려 좋지 못한 예도 있음을 확인하였다. 이를 위한 추가 연구가 필요하지만, 균열 발생 위치가 다양한 공동주택의 특성상 단색의 콘크리트 균열 탐지에 효과적인 정규화 기법이 오탐균열 탐지에 대해서는 효과가 크지 않은 것으로 나타났다. 색상 모델의 경우 다른 색상 모델보다 RGB를 적용한 결과가 대체로 균열 탐지 성능이 우수하게 나타났다. 오탐균열 탐지의 경우에는 LAB 색상 모델을 적용한 판단 결과가 RGB 색상 모델 결과보다 우수하게 나타났으나, 전체 데이터를 대상으로 한 검증에서는 RGB 모델이 여전히 더 우수한 균열 및 오탐균열 탐지 결과를 보여주었다.

결과적으로 본 연구를 통해 일반적인 균열 탐지에 적용된 이미지 정규화 기법이 공동주택 균열 탐지에는 효과적이지 않을 수 있다는 것과 타 색상 모델 대비 RGB 색상 모델이 더 효과적이라는 것을 확인하였다. 그러나 일부 오탐균열 형태의 경우 특정 색상모델에서 RGB 모델보다 높은 정확도를 나타냈다. 따라서 본 연구를 바탕으로 색상 채널의 다양한 조합을 통해 공동 주택에서 발견되는 오탐균열에 대한 탐지 정확성을 보다 향상하기 위한 추가 연구가 필요하다.